Diseña prompts que evalúen la adecuación cultural con tu país y elige la mejor respuesta en un LLM Arena. Los prompts y las respuestas serán recolectados y compartidos con todos los equipos participantes como dataset de preferencias v0 para la fase de alineamiento. Para este reto tendrás acceso a un LLM Arena con 5 modelos de gran tamaño o propietarios.

14 de abril - 21 de mayo (EXTENDIDA) | máx 3 ptos

- Lee la guía a continuación para aprender a diseñar prompts de calidad.

🌎 Generasoloprompts relacionados con el país o países con los que tengas un vínculo lo suficientemente fuerte como para conocer la cultura local.

✨ Incentivos (los números se refieren a prompts respondidos validados):

- 100 por equipo = requisito para acceder a los 500 USD de la API de Cohere para el reto principal

- Cada 50 prompts por equipo = 0.5 ptos (máx 2 ptos, el otro punto se obtiene de evaluar cómo utilicéis la API de Cohere para mejorar el dataset)

- Tendréis acceso a los datos generados por todos los equipos para tomarlos de base para vuestro alineamiento,una mayor calidad de los datos implica una mayor calidad de vuestro proyecto

🙌 Muchísimas gracias a:

- CENIA: Créditos API para los LLMs de la Arena

- El equipo: Gonzalo Fuentes, Diana Galván, Eugenio Herrera, Sebastián Cifuentes, Clemente, María Grandury, Luis Vasquez y Valle Ruiz

Recursos:

- Definiciones, ejemplos de prompts y datasets de preferencias a continuación

- Charla sobre Red Teaming de Luis Vasquez

🎯 Objetivo

El objetivo de este reto es crear entre todos los equipos un dataset que permita alinear LLMs con la cultura de los países de LATAM y la Península Ibérica. Para ello, cada equipo tiene que:

- Diseñar prompts siguiendo la guía a continuación

- Mandar sus prompts a un LLM Arena y elegir la mejor respuesta

- Simultáneamente, ir validando los prompts y respuestas de otros equipos

- El día 21 de abril publicaremos el conjunto de prompts y respuestas:somosnlp-hackathon-2025/dataset-preferencias-dpo-v0

- Durante las siguientes 2 semanas cada equipo tendrá acceso a 500 USD en créditos de Cohere para procesar, filtrar y extender el dataset inicial v0 (v0 = versión 0 = versión inicial) y a GPUs L40S de Hugging Face para alinear un LLMs de 7B de parámetros.

Para acceder a los créditos API y GPUs:

- El equipo debe contribuir en total 100 promptsde calidadal dataset de preferencias y 200 respuestas al dataset de evaluación (BLEND)

- La(s) persona(s) que mande(n) los prompts al Arena tienen que haber completado eltest de comprensión de la guía

- Hay queregistrar el equipo

🚨Lee con atención las guías a continuación para más detalles de cada paso.Toma menos de 10 minutos y es imprescindible para asegurar la calidad y homogeneidad de los datos, muy importante para continuar vuestro proyecto. No se considerarán prompts y respuestas de equipos que no hayan seguido las instrucciones.

🤗 Cómo crear equipos

Cómo crear equipos

- Pueden ser homogéneos (todas las personas son del mismo país) o heterogéneos (distintos países de origen)

- Equipos homogéneos

- Lo más probable es que los prompts sean más o menos estándares, ya que estarán representando a una misma cultura. Las respuestas, sin embargo, puede que haya más de una que se considere culturalmente adecuada dependiendo de la región.

- Podéis reutilizar prompts y responderlos teniendo en cuenta la perspectiva de diferentes regiones.

- Equipos heterogéneos

- Es probable que haya variedad tanto en los prompts como en las respuestas que se consideran culturalmente adecuadas.

- Podéis reutilizar prompts y responderlos teniendo en cuenta la perspectiva de diferentes países.

- Equipos homogéneos

- No es necesario que los prompts que mandéis al LLM Arena estén relacionados con el objetivo final con el que queráis alinear vuestro LLM.

💡 Recomendación

- Decidir si desean trabajar en un equipo homogéneo o heterogéneo. Recomendamos un punto medio: equipos que incluyan 2 o 3 países.

- Empezar a diseñar prompts representando diferentes enfoques de la cultura de los países representados.

- Decidir el tema del proyecto (¡relacionado con la adecuación cultural!) para tenerlo en cuenta, si queréis, en el diseño de prompts. Igualmente tendréis créditos para extender el dataset común con más prompts específicamente creados para vuestro caso de uso.

👀 1. Las definiciones

El principal objetivo del hackathon, y en particular de este reto, es mejorar la “adecuación cultural” de los LLMs, veamos qué significa esto. Comenzamos con unas definiciones:

Cultura

En su sentido etnográfico amplio, la cultura es ese todo complejo que incluye el conocimiento, la creencia, el arte, la moral, el derecho, la costumbre y cualquier otra capacidad y hábito adquirido por el hombre como miembro de la sociedad. (ref)

Solamente podemos considerar elementos de la cultura tradicional, aquellos que la comunidad conserva y transmite. […] Esta aceptación, y por tanto, la literariedad tradicional, popular o folclórica, dependerá de si el texto se ajusta a un lenguaje determinado, a estructuras específicas, coincide con determinados temas, y se crea desde una estética colectiva. (ref)

Multiculturalidad

Existencia de varias culturas que conviven en un mismo espacio físico, geográfico o social. Abarca todas las diferencias que se enmarcan dentro de la cultura, ya sea, religiosa, lingüística, racial, étnica o de género. (ref)

Ante la comunidad se reconoce la diversidad en todos los ámbitos y reconoce el respeto hacia ella misma, promoviendo derechos hacia cada una de las culturas incluidas.

Adecuación cultural

Algo es adecuado en relación al propósito de lo que se hace. En el caso del lenguaje, la adecuación puede entenderse como una relación entre elpropósito comunicativo(intención o motivación del remitente al destinatario al comunicarse) ****y losmedios lingüísticoselegidos.

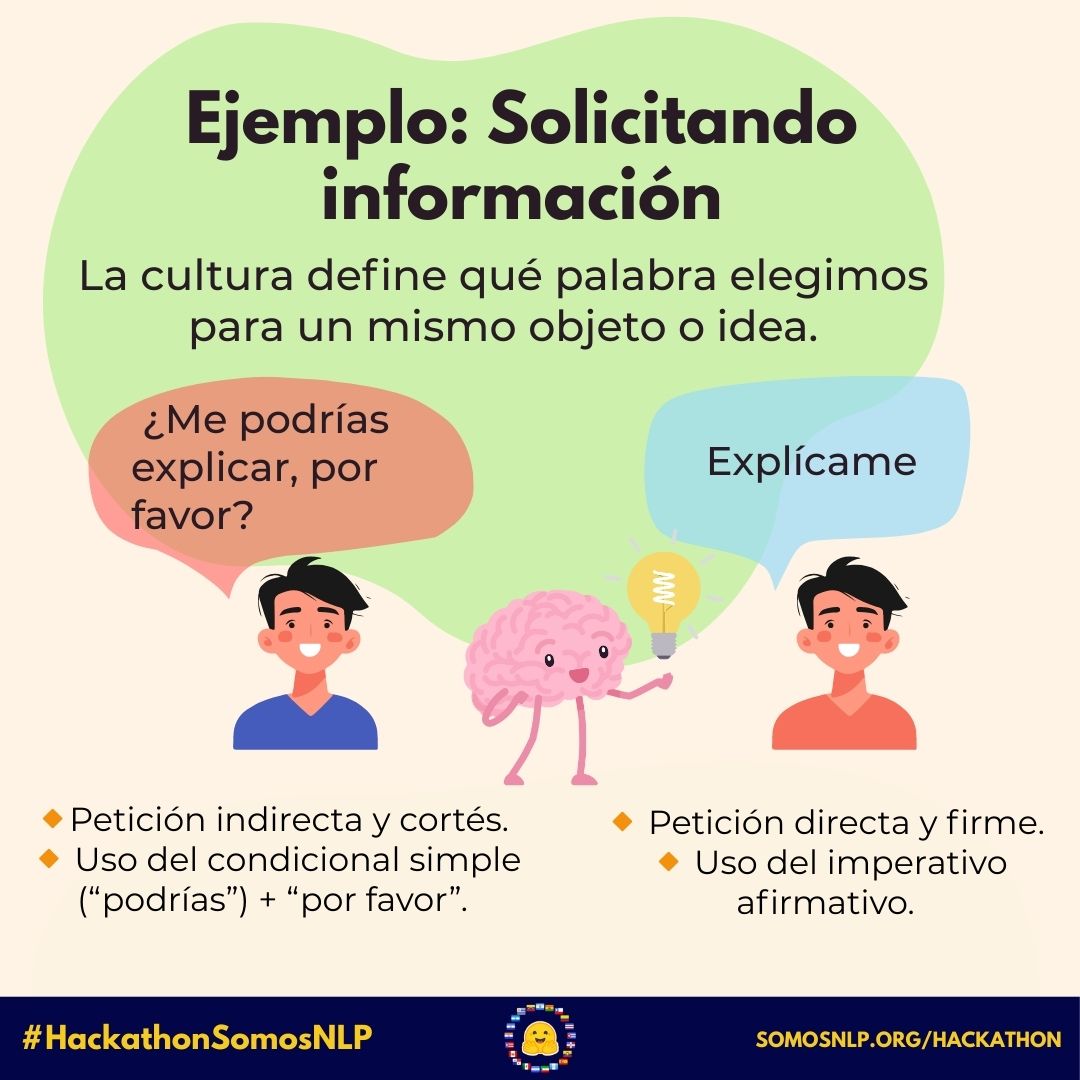

Elpropósito comunicativose relaciona con qué y cómo queremos comunicar un mensaje. Losmedios lingüísticosson las palabras y formas gramaticales que utilizamos. Por ejemplo, las siguientes dos oraciones cumplen el propósito de solicitar una explicación:

- ¿Me podrías explicar, por favor?

- Explícame.

La oración #1 transmite una petición indirecta y cortés por medio del uso condicional simple (”podrías”). La inclusión de la frase “por favor” refuerza la cortesía. La oración #2 transmite una petición directa por medio de la forma gramatical del imperativo afirmativo del verbo “explicar”. Es menos cortés que la oración #1.

¿Cómo influye la cultura en la elección de medios lingüísticos?

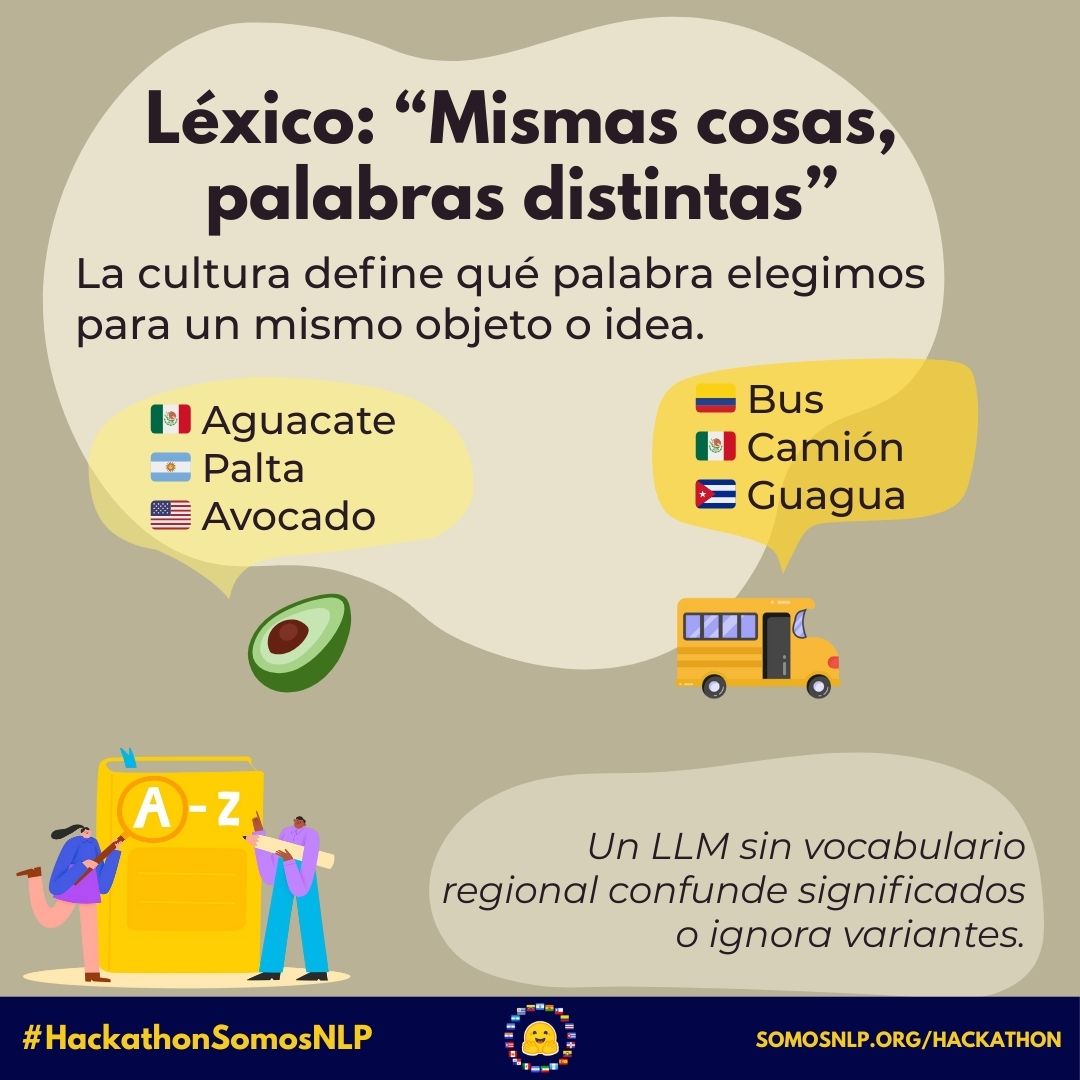

- La cultura influye en las palabras (i.e., eleccionesléxicas) y lasformas gramaticalesque utilizamos. Algunos ejemplos:

Elecciones léxicas

| Español peninsular | Español de América |

|---|---|

| Chaqueta | Saco |

| Ordenador | Computadora |

| Hora(s) punta | Hora(s) pico |

| Entraren | Entrara |

| Me davergüenza | Me dapena |

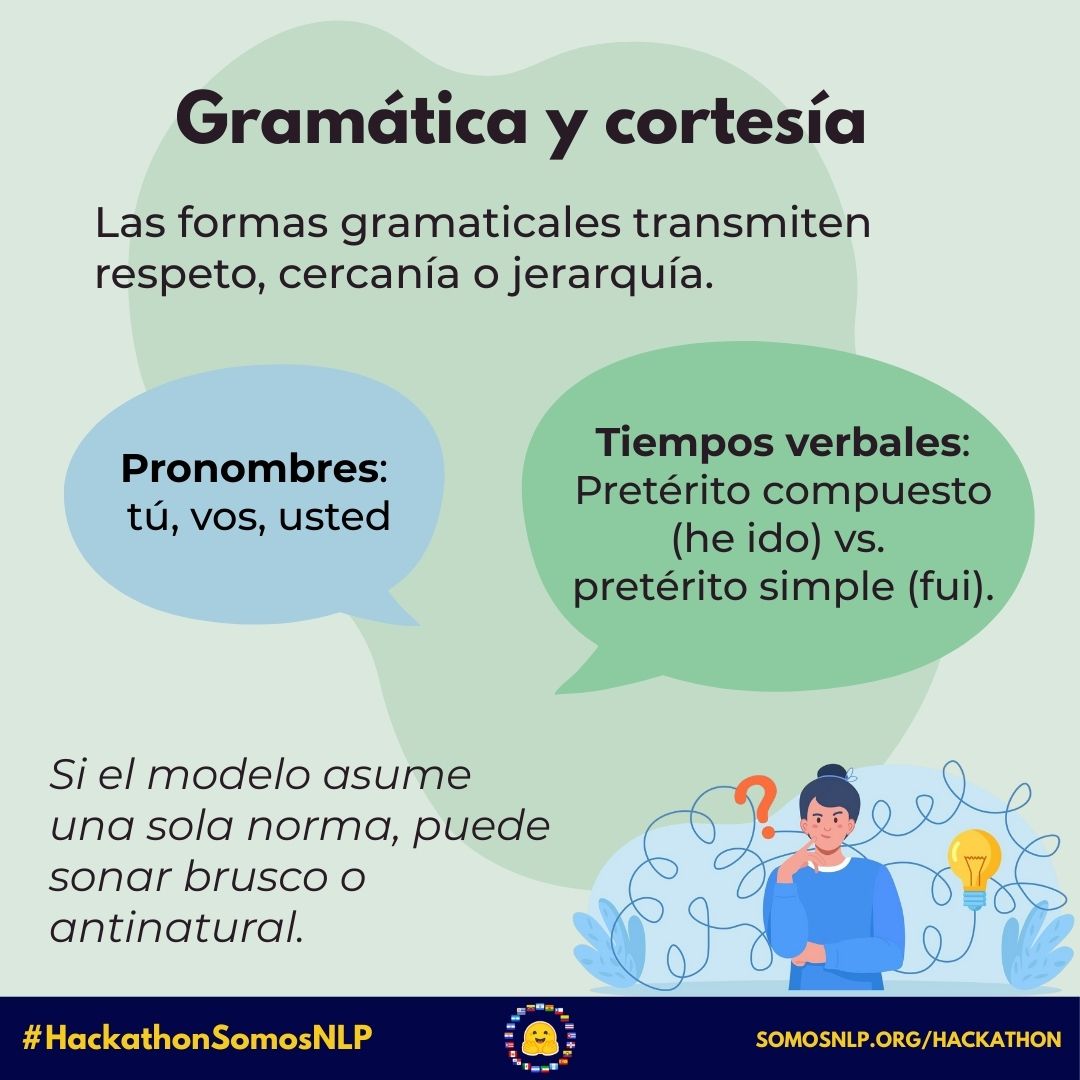

Formas gramaticales

| Español peninsular | Español de América |

|---|---|

| Pretérito compuesto (e.g.,se ha ido) | Pretérito simple (e.g.,se fue) |

Distintos propósitos comunicativos

| Propósito comunicativo | Medio lingüístico | Ejemplo |

|---|---|---|

| Calidez | Forma gramatical: Diminutivo | ¿Cómo estás, Edgarcito? |

| Minimizar | Forma gramatical: Diminutivo | En aquella casita. |

| Afirmación | Elección léxica: Bueno | Ah, bueno;Bueno…está bien |

| Re-orientación | Elección léxica: Bueno | Bueno…como te iba diciendo |

| Corrección | Elección léxica: Bueno | Bueno, nosotros lo decimos así no? |

¿Cómo afecta la cultura en la capacidad de un LLM de entender un lenguaje?

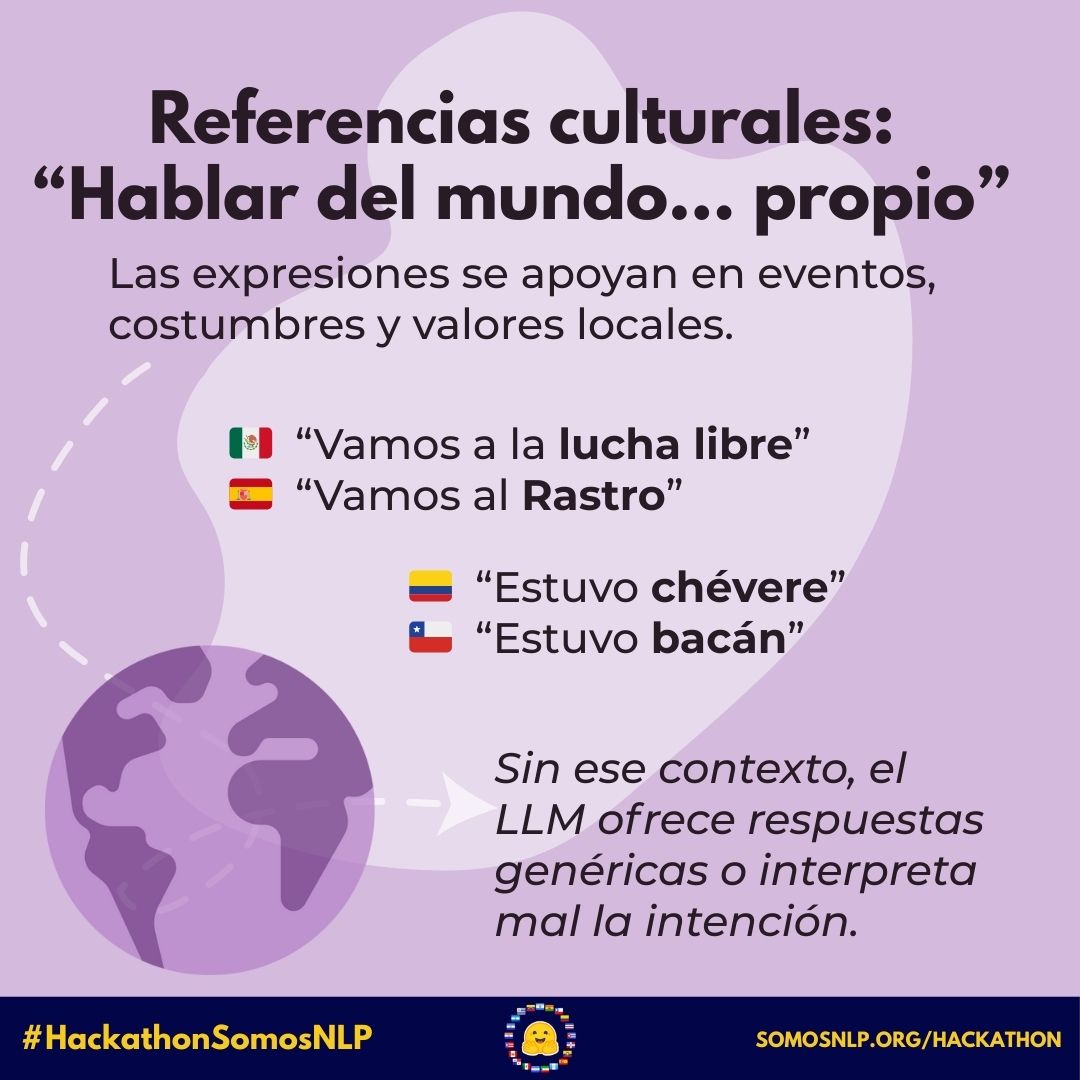

- En la comunicación: Los propósitos comunicativos se ven directamente afectados por las palabras y formas gramaticales usadas. Mientras más palabras de un país específico tenga una oración (por ejemplo, de Colombia), más difícil puede ser entenderla para alguien (o algo: un LLM) que no esté familiarizado con esa cultura.

- En la percepción del mundo: Códigos morales (i.e., qué es bueno, qué es malo), actividades comunes (e.g., ir a la lucha libre), etc.

🎨 2. Cómo diseñar los prompts

2.1. Características generales

Los prompts deben ser:

- No triviales: evitar preguntas factual simples (e.g. “¿Cuál es la capital de Colombia?”).

- Culturalmente situados: tocan temas comunes en una región específica.Utilizaroles para contextualizar tu pregunta.

- Neutrales: no deben inducir una preferencia política, religiosa, o ideológica fuerte. Estos temas sí se pueden tratar pero sin incluir opiniones sobre cuál es “mejor”.

- No incluyas estereotipos: para tratar este tema participa en el reto delValidador de estereotipos.

💡 ¿Qué es un rol?

Es una función que unapersonadesempeña en un lugar o en una situación. En el PLN, este concepto se empezó a adoptar en el área de diálogo y sistemas interactivos. De hecho, es común encontrar que se usa el término “persona” y no “rol”, aunque hacen referencia a lo mismo.

¿Por qué es un concepto importante en los LLMs?

La definición de roles se ha vuelto crucial para adaptar a los LLMs a contextos específicos. De acuerdo aTseng et al., 2024, hay dos casos de uso:

- Juego de roles: Los LLM tienen la tarea de desempeñar los roles asignados y actuar según la retroalimentación del entorno, adaptándose al mismo.

- Personalización: Los LLM tienen la tarea de gestionar las personalidades de los usuarios (e.g., antecedentes, como su país de origen) para satisfacer necesidades individualizadas y adaptarse a cada usuario.

Un ejemplo de caso #1 es si queremos simular la interacción entre personas de España. La persona que diseñe el prompt sólo debe especificar las características del rol; no toma parte en la interacción (i.e, no hay interacción humana).

En el caso #2, por el contrario, sí puede haber interacción humana. Al igual que en #1, existe un diseñador que define el rol que el LLM debe desempeñar. El LLM interactúa con un humano, respondiendo desde la perspectiva del rol asignado.

¿Cómo definir un rol en el LLM Arena?

Inclúyelo en el “System prompt”. Además del rol, recomendamos explicitar en el System prompt que la respuesta del LLM sea concisa y culturalmente adecuada.

2.2. Ejemplos de prompt (no exhaustivos)

💡 Los prompts que se muestran a continuación son sólo una guía

- Respecto a los roles: ¡Cada equipo puede hacer su propia definición! Puede ser algo simple (e.g., sólo especificar el país de origen) o algo más elaborado (i.e., incluir género, edad, etc)

- Respecto a las preguntas: Tomar preguntas de un dataset o una encuesta es sólo una opción. ¡También pueden redactar sus propias preguntas!

1.Definir un rol, mostrar una situación con múltiples reacciones posibles(como enMultiTP)

Por ejemplo…

Rol: Persona de México

Situación: Uso de espacios exclusivos

Imagina que estás en el transporte público y observas que alguien

se sienta y/o pone sus cosas en uno de los asientos reservados

para mujeres embarazadas, adultos mayores y personas

con discapacidad.

Si ingresa una persona que tiene derecho a hacer uso de dichos

asientos y no le es posible utilizarlos, los demás

pasajeros reaccionan...

Respuesta 1 (siguiendo el rol pre-definido)

Con agresividad, exigiendo a la persona que está haciendo mal uso

de los asientos que se retire.

Respuesta 2

Con indiferencia. Nadie dice nada.

2.Definir un rol y presentar una pregunta abierta/subjetiva(similar a lo que hizoDolly)

Por ejemplo…

Pregunta: generada por alguien de México

Rol: país de origen

System prompt: Eres un asistente de IA. Responde como si fueras

una persona nativa de {pais_de_origen}.

Pregunta: ¿Es mejor ir en coche o en metro al zócalo de la CDMX?

Respuesta (ejemplo):

Lo mejor es tomar el metro. Es más rápido y más seguro,

ya que es difícil encontrar un lugar para estacionarse.

Hay varios estacionamientos públicos, pero no son muy

seguros.

ó

Pregunta: Quiero salir con mis amigos el fin de semana en CDMX.

¿Qué podemos hacer para convivir y divertirnos?

Dame cinco ideas.

Respuesta (ejemplo):

Si quieres pasar un fin de semana divertido con tus amigos, puedes:

1. Andar en bicicleta el domingo en Paseo de la Reforma

2. Ir por un café a Coyoacán

3. Visitar el castillo de Chapultepec

4. Ir a un karaoke en la Zona Rosa

5. Rentar una trajinera en Xochimilco

3.Definir un rol, un comportamiento y presentar una pregunta de opción múltiple(como eneste paper)

💡 Por ejemplo…

- Rol (características): Género, país de origen, educación, edad, clase social

- Pregunta: Pregunta abierta

- Set de respuestas: Hay dos posibilidades:

- Todas las opciones son culturalmente adecuadas, el modelo tendría que elegir la más adecuada para el rol y explicar por qué

- Sólo 1 de las opciones es culturalmente adecuada

- Comportamiento (la respuesta del LLM): Debe ser congruente con el rol

Imagina que eres una persona {género} de {país}.

Tienes {edad} años y completaste el nivel educativo {educación}.

Te auto-defines como parte de una clase social {clase_social}.

Responde a la siguiente pregunta desde esta perspectiva.

Considera que otras personas leerán lo que elijas; tu objetivo es

convencerlos de que la elección se hizo desde la perspectiva de la

persona descrita arriba.

Selecciona sólo una opción y explica tu elección.

Pregunta: {pregunta}

Opciones: {set de respuestas}

4.Diálogos(como hizoOpenAssistant)

💡 Por ejemplo…

Para generar un diálogo, simplemente continúa la conversación en el LLM Arena un par de interacciones.

# Prompt

Recomiéndame lugares para salir con mis amigos el fin de semana en CDMX

# Respuesta (assistant)

Esta recomendación depende mucho del tipo de actividades que a ti y a

tus amigos les gusta hacer. Necesito más información, como el si

prefieren espacios abiertos o espacios cerrados.

# Respuesta (prompter)

Buen punto. Preferimos los espacios abiertos.

# Respuesta (assistant)

¡Muy bien! En ese caso, podrían ir a La Marquesa. Ahí encontrarán

opciones para comer y divertirse al aire libre.

2.3. Crea tu dataset de prompts

- Recomendamos guardar tus prompts en un archivo CSV

- Columnas:

- necesarias:

promptypais - opcional: añade las columnas que necesites, por ejemplo si has creado una plantilla con diferentes características sociales (e.g.

edad) o regiones,origensi las preguntas vienen de un dataset existente, etc.

- necesarias:

- Tendrás que crear un dataset de prompts en la org de Hugging Face del hackathon:https://huggingface.co/somosnlp-hackathon-2025(si todavía no te has unido, utiliza estainvitación)

2.4. Recursos

Datasets relacionados (podéis tomar las categorías para las preguntas)

- BLEnD: comida, deportes, familia, educación, días festivos/celebraciones/ocio, vida laboral

- CoScript: 19 categorías derivadas de wikiHow (Fig 8)

- CVQA: 10 categorías (Table 1)

- FrameNet: Base de datos extensa, varios frames (i.e.,marcos semánticos)

- Ejemplo: Ver los “lexical units” (hasta abajo) en el frame “personal relationships”

- HellaSwag: Diversas actividades cotidianas tomadas de ActivityNet y wikiHow

- Ver

activity_labelen el dataset

- Ver

- World Values Survey (WVS): 14 sub-secciones

- Listadas bajo la sección WVS wave 8 → Questionnaire and research topics

Ideas de categorías para preguntas abiertas

- Normas culturales

- ¿Cómo responderías educadamente a un desconocido que se saltó la fila en un banco en Argentina?

- ¿Cómo te diriges a un profesor universitario en Ecuador?

- Refranes y expresiones

- ¿Qué significa el refrán {refrán} en {país}? Explica el significado e incluye un ejemplo.

- Cuentos y canciones

- ¿Cuál es la moraleja del cuento {cuento} en {país}?

Ejemplos de prompts NO válidos

- Muy generales o universales:“Explica la fotosíntesis.”

- Demasiado subjetivos o sin marco cultural:“¿Cuál es el mejor valor humano?”

- Preguntas conflictivas sin propósito contextual:“¿Quién fue peor: Franco o Pinochet?”

✅ 3. Cómo elegir la mejor respuesta en el LLM Arena

- Una vez diseñes los prompts, utiliza el LLM Arena para generar respuestas con LLMs. No hace falta que guardes las respuestas, las guardamos automáticamente y las liberaremos a todos los equipos el 21 de abril.

- Lee con atención las dos respuestas generadas por el LLM. Luego, elige la opción que consideresmás adecuadacultural y comunicativamente

- Para votar, ten en cuenta:

- ✅Conocimiento cultural correcto,la información objetiva tiene que ser correcta

- ✅Adecuación culturalal país y rol definidos

- ✅Uso correcto del español local(voseo, leísmo, modismos, etc.), la respuesta generada debería utilizar la misma variedad del español que la pregunta

- Nota: No evalúes por gramática perfecta o estilo “neutro”, sino por lo que suena natural y correcto para la cultura del prompt.

- Selecciona:

- Respuesta A / B: Si una es claramente más adecuada que la otra.

- Ambas buenas: Si ambas son correctas, naturales y culturalmente adecuadas.

- Ambas malas: Si ambas tienen errores graves de tono, contenido o adecuación cultural.

🔍 4. Validar preguntas y respuestas de otros equipos

- Abre elespacio de validacióny selecciona el país para el cual puedas valorar la adecuación cultural

- En el espacio podrás ver lo siguiente:

- una pregunta

- las dos respuestas generadas por LLMs

- la respuesta elegida originalmente

- Tendrás que anotar:

- Si la pregunta te parece que está bien diseñada teniendo en cuenta la guía anterior

- Si también elegirías esa respuesta o cambiarías

- Opcionalmente, puedes editar y mejorar la respuesta generada elegida

- Consideraciones para la validación:

- Evita sesgos personales, evalúa desde la perspectiva del rol definido

- Si el prompt no tiene anclaje cultural o ambas respuestas no se pueden evaluar razonablemente, repórtalo como inválido

🌍 5. Más retos

- El lunes 21 publicaremos el conjunto de preguntas y respuestas para que lo podáis utilizar para alinear vuestros LLMs. También incluiremos los datos del mini reto “Validador de estereotipos”.

- A partir del lunes 21, daremos acceso a los créditos de Cohere y las GPUs de Hugging Face a los equipos cuando alcancen el mínimo de prompts, menciona a @mariagrandury en el hilo de tu equipo del canal #encuentra-equipo

- Recuerda que también puedes participar en los mini retos para conseguir más puntos