Presentamos

SomosNLP

Somos una comunidad internacional de personas hispanohablantes apasionadas por el PLN. Nuestra misión es acercar la IA a 600 millones de personas hispanohablantes alrededor del mundo. Y nuestra visión, conseguir una justa representación del español y lenguas cooficiales en el mundo digital.

Proyectos actuales

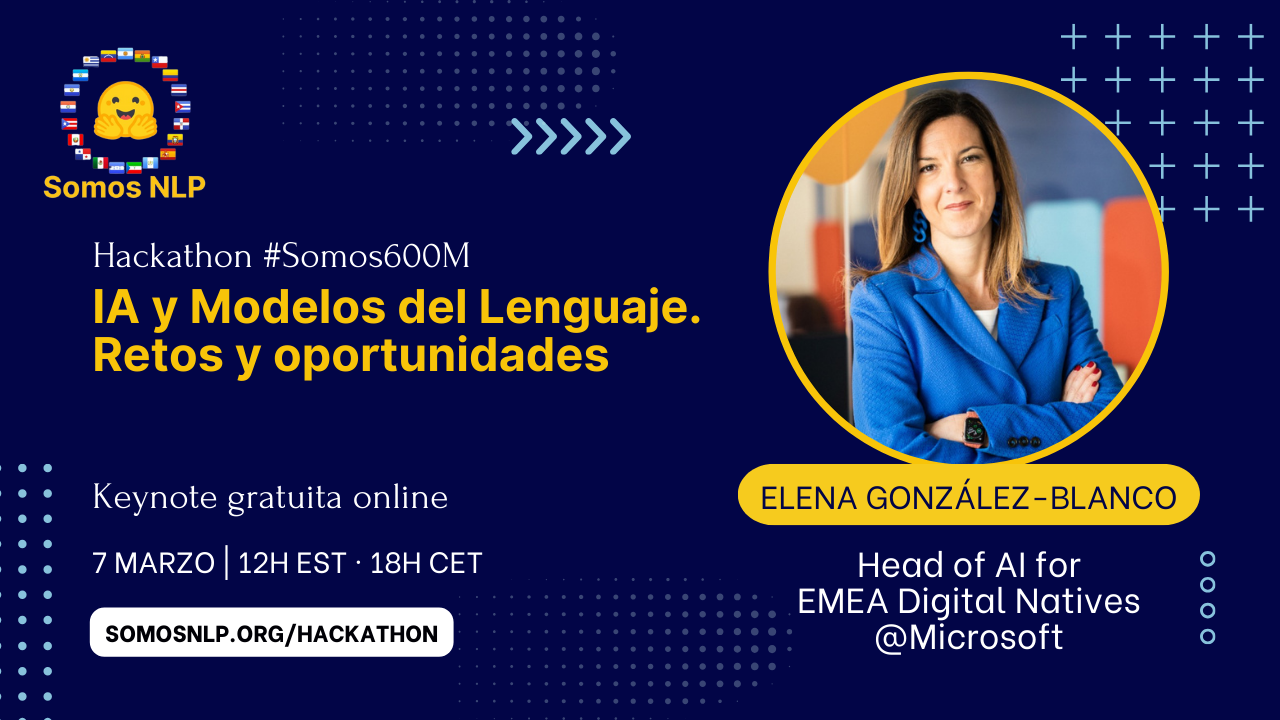

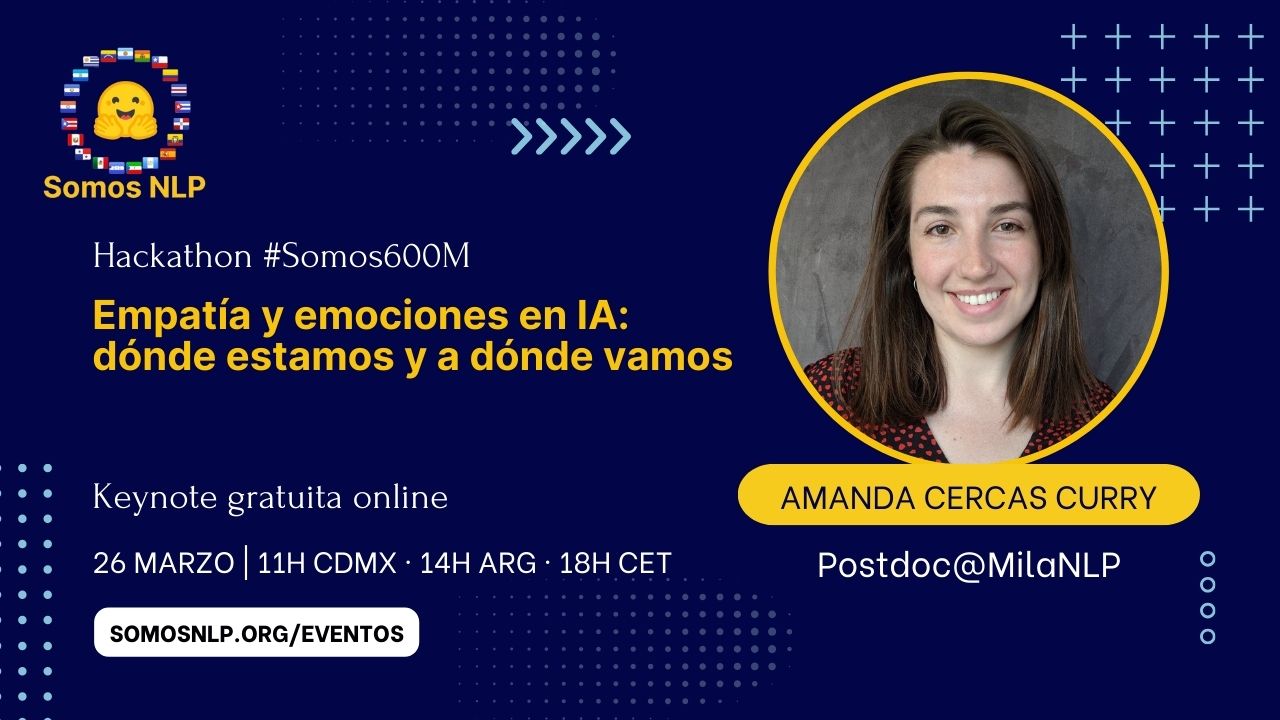

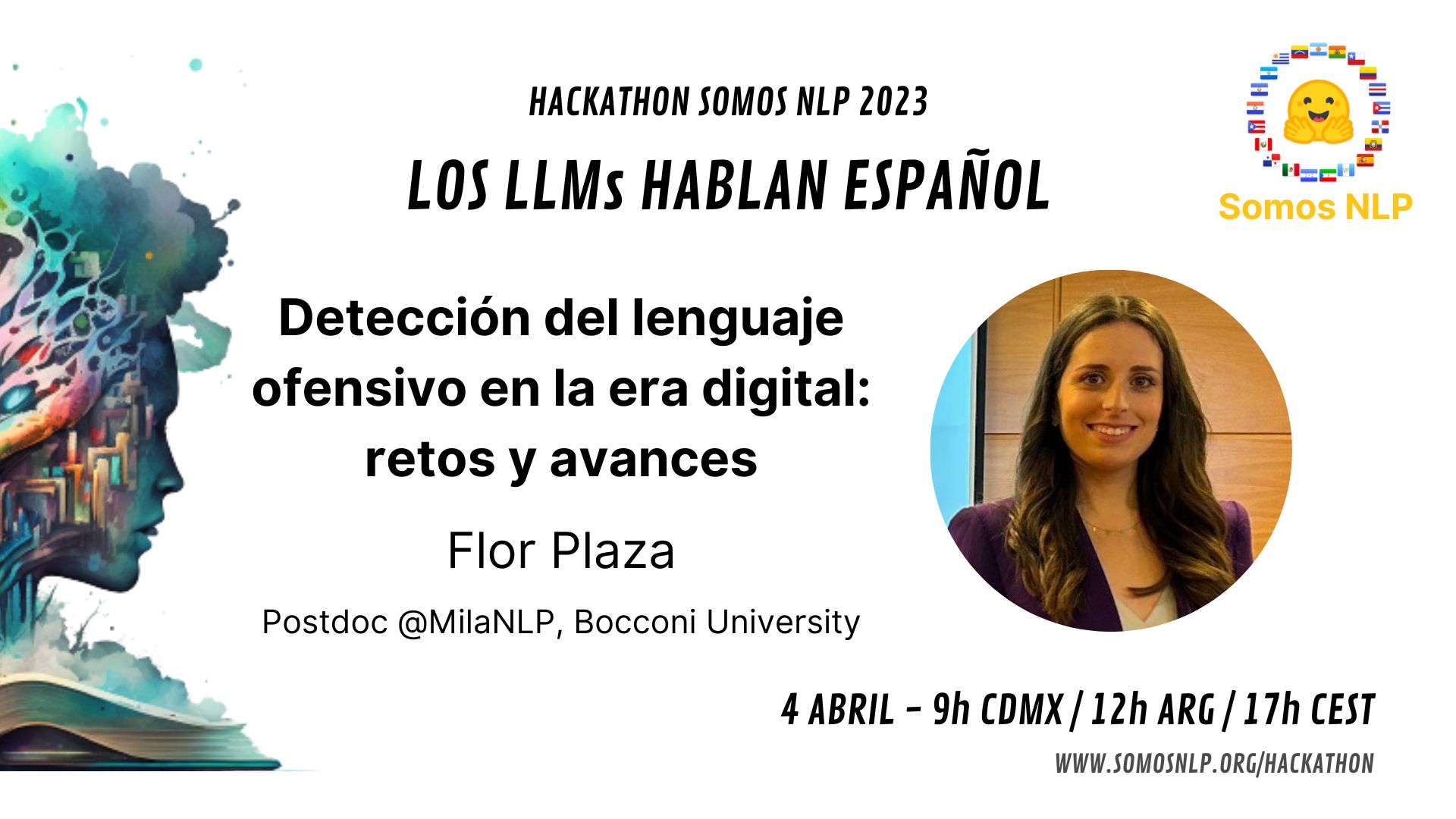

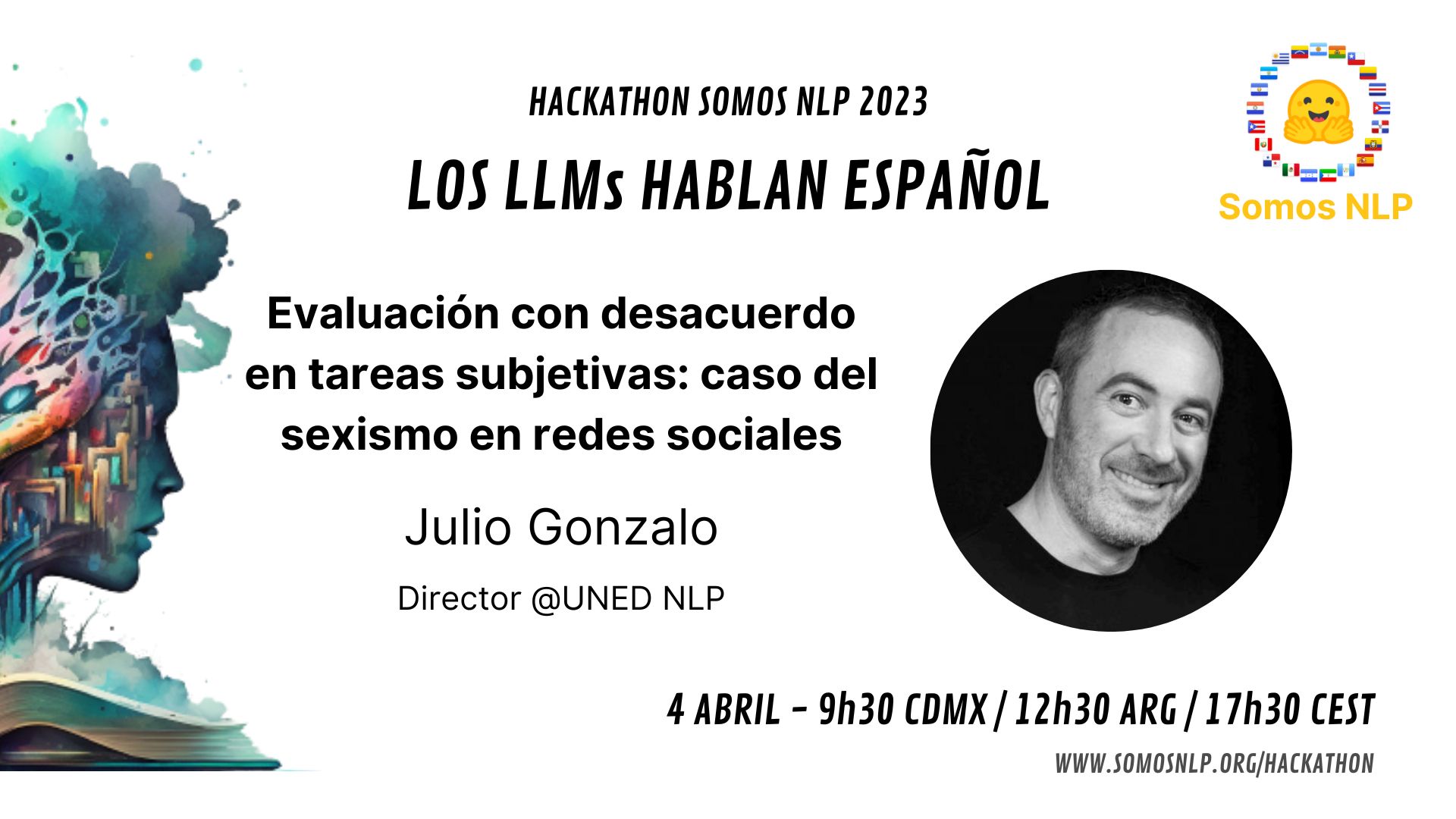

Hemos lanzado el Proyecto #Somos600M con el objetivo de representar en los modelos de lenguaje la riqueza de nuestras lenguas. Tenemos varias iniciativas:

Buscamos colaboraciones con grupos de investigación de LATAM, el Caribe y España, ¡contáctanos!

Saber másCasi 600M de hispanohablantes*

¡Somos el 7.5% de la población mundial! La investigación en PLN está centrada en el inglés y descuida las dificultades particulares de los otros idiomas. Vamos a darle a nuestro idioma tan extendido y colorido una representación justa en el ámbito del PLN. Nuestra misión es impulsar el desarrollo del PLN en español, ¿cómo?

* "El español en cifras", El español en el mundo, Anuario del Instituto Cervantes 2024

¡Contribuye!

Somos una comunidad internacional y todos nuestros proyectos son open source.